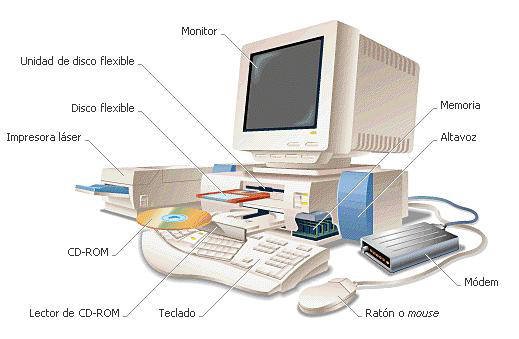

El Transistor es un dispositivo electrónico semiconductor que cumple funciones de amplificador, oscilador, conmutador o rectificador. El término "transistor" es la contracción en inglés de transfer resistor ("resistencia de transferencia"). Actualmente se los encuentra prácticamente en todos los enseres domésticos de uso diario: radios, televisores, grabadores, reproductores de audio y vídeo, hornos de microondas, lavadoras, automóviles, equipos de refrigeración, alarmas, relojes de cuarzo, computadoras, calculadoras, impresoras, lámparas fluorescentes, equipos de rayos X, tomógrafos, ecógrafos, reproductores mp3, celulares, etc.

Sustituto de válvula termoiónica de tres electrodos o triodo, el transistor bipolar fue inventado en los Laboratorios Bell de EE. UU. en diciembre de 1947 por John Bardeen, Walter Houser Brattain y William Bradford Shockley, quienes fueron galardonados con el Premio Nobel de Física en 1956.

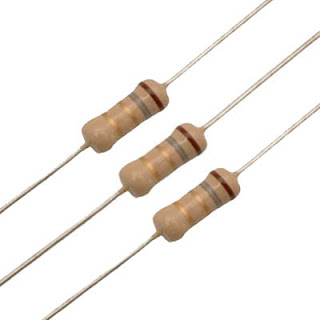

El transistor consta de un sustrato (usualmente silicio) y tres partes dopadas artificialmente (contaminadas con materiales específicos en cantidades específicos) que forman dos uniones bipolares, el emisor que emite portadores, el colector que los recibe o recolecta y la tercera, que está intercalada entre las dos primeras, modula el paso de dichos portadores (base). A diferencia de las válvulas, el transistor es un dispositivo controlado por corriente y del que se obtiene corriente amplificada. En el diseño de circuitos a los transistores se les considera un elemento activo, a diferencia de los resistores, capacitores e inductores que son elementos pasivos. Su funcionamiento sólo puede explicarse mediante mecánica cuántica.

.jpg)

Su principal competidor es Microsoft expresión Web .Tiene soporte tanto para edición de imágenes como para animación a través de su integración con otras herramientas.

Hasta la versión MX, fue duramente criticado por su escaso soporte de los estándares de la Web, ya que el código que generaba era con frecuencia sólo válido para

Su principal competidor es Microsoft expresión Web .Tiene soporte tanto para edición de imágenes como para animación a través de su integración con otras herramientas.

Hasta la versión MX, fue duramente criticado por su escaso soporte de los estándares de la Web, ya que el código que generaba era con frecuencia sólo válido para